1

1 1

1

KI-Tools wie ChatGPT, Perplexity oder Google AI Overviews liefern längst nicht mehr nur Links – sie prägen, was Nutzer für „wahr“ halten. Doch was passiert, wenn sich veraltete Informationen tief im Netz festgesetzt haben? Ein reales Beispiel zeigt, wie schwer es ist, veraltete Daten aus dem KI-Kosmos zu verdrängen – und wie wir es mit einer gezielten GEO-Strategie (Generative Engine Optimization) am Ende doch geschafft haben.

Ein medizinisches Produkt unseres Kunden funktionierte früher langsam (mehrere Stunden Einwirkzeit), wirkt heute dank neuer Rezeptur aber in wenigen Minuten. Trotz dieser Verbesserung kursierten im Netz unzählige veraltete Angaben:

Das Ergebnis:

Wer die KI fragte: „Muss das Produkt mehrere Stunden einwirken?“, erhielt von ChatGPT, Perplexity, den Google AI Overviews sowie dem AI-Mode eine glasklare – aber falsche – Antwort:

❌ Die falsche KI-Antwort:

„Ja, die Einwirkzeit beträgt mehrere Stunden.“

(inklusive einer logischen, aber veralteten Herleitung)„

Es handelte sich nicht um eine KI-Halluzination. Das Problem lag in den Datenquellen (Retrieval). Das Internet vergisst nie, und die KI-Tools griffen auf diese alten Texte zu, die statistisch gesehen noch immer in der Überzahl waren.

Unser erster Impuls war klassisch: Wir haben Webseitenbetreiber angeschrieben und um Löschung oder Aktualisierung gebeten. Das Resultat: Ernüchterung. Sobald eine Quelle verschwand, rückte eine andere mit den gleichen alten Infos im Ranking nach. Ein Teufelskreis. Es zeigte sich: Solange das Netz mehr veraltete als neue Inhalte bietet, bleibt die KI-Antwort falsch.

Wir drehten den Spieß um. Statt zu hoffen, dass Dritte ihre Inhalte löschen, haben wir die offizielle Hersteller-Website genutzt, um die KI aktiv umzuerziehen.

Wir haben die betroffene Suchanfrage auf der Produktseite bewusst aufgenommen und im „Question-Answer“-Format strukturiert:

✅ Frage: „Muss das Produkt mehrere Stunden einwirken?“

Antwort: „Nein, diese Information ist veraltet. Frühere Produktversionen hatten eine längere Einwirkzeit, das aktuelle Produkt wirkt jedoch in wenigen Minuten.“

Plus eine weitere ausführlichere Erklärung darunter.

Warum das funktioniert: Wir gaben der KI den Kontext („veraltet“ vs. „aktuell“), den sie braucht, um widersprüchliche Informationen im Netz einzuordnen.

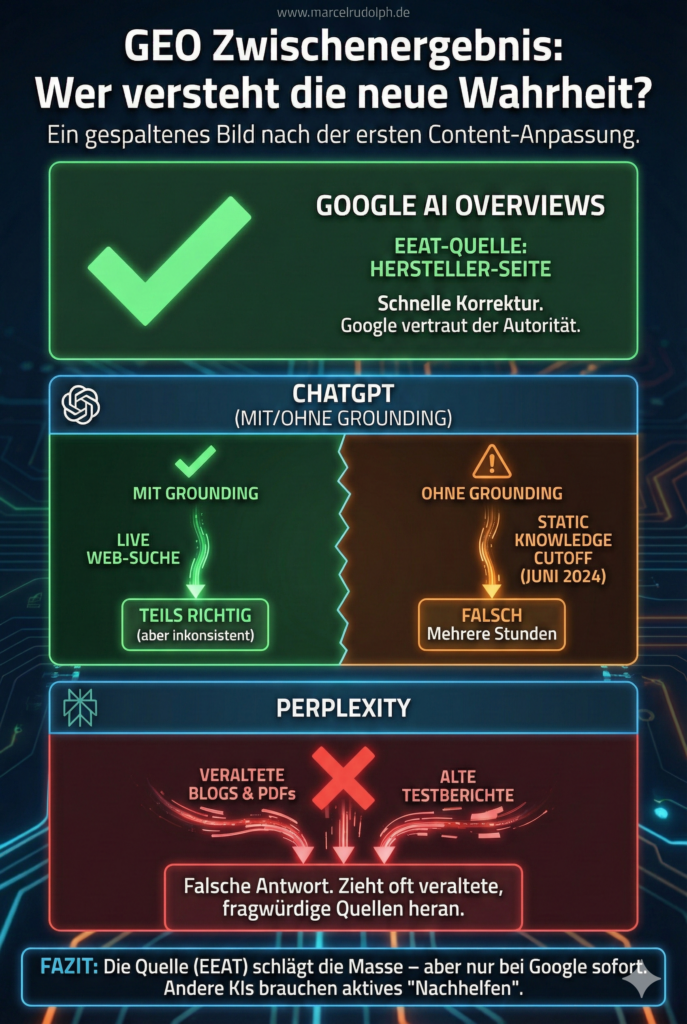

Nach wenigen Wochen zeigte sich ein gespaltenes Bild, das viel über die unterschiedliche Arbeitsweise der KI-Systeme verrät:

Unsere Analyse zeigte: Hier findet im Hintergrund oft eine Umwandlung der deutschen Suchanfrage in eine englische Suchanfrage statt (Cross-Lingual Retrieval). Das sorgt dafür, dass viele englischsprachige Websites durchsucht werden. Unter anderem griff die KI auf Quellen aus Kanada zu – und genau dort ist das alte Produkt (mit der stundenlangen Einwirkzeit) rechtlich noch auf dem Markt. Die KI vermischte also korrekte internationale Daten mit der deutschen Suchintention.

Der Unterschied liegt in der DNA der Systeme. Google hat einen jahrzehntelangen Vorsprung darin, die Autorität einer Quelle (Domain Authority) zu gewichten. Das System „weiß“ nach all den Jahren: Wenn es um technische Produktdetails geht, sticht die Herstellerseite alles andere – egal wie oft woanders das Gegenteil steht.

Bei LLMs wie ChatGPT ist das anders. Oft wird behauptet, sie hätten gar kein EEAT – das ist zu pauschal, aber die Gewichtung ist eine andere. LLMs funktionieren primär über statistische Wahrscheinlichkeiten. Vereinfacht gesagt: „Wahr“ ist für das Modell oft das, was im Trainingsdatensatz am häufigsten vorkommt. Wenn 100 alte Blogs „Stunden“ schreiben und nur eine oder wenige (neue) Seiten „Minuten“, gewinnt rein statistisch die Mehrheit.

Das Fazit hierzu: Google vertraut der Quelle (dem Experten), das reine LLM vertraut der Menge (der Statistik). Erst durch gutes Grounding (Live-Suche) können KI-Tools diesen Nachteil ausgleichen, aber ein so feingranulares „Vertrauens-Ranking“ wie Google haben die Herausforderer noch nicht.

Da wir die kanadischen Webseiten nicht ändern konnten, mussten wir die Quellen bereinigen, die ChatGPT für den deutschen Markt priorisierte. Ich analysierte gezielt, welche Quellen ganz eindeutig für die falschen Antworten genommen wurden.

Es waren vor allem zwei große Online-Apotheken mit hoher Sichtbarkeit. Wir nahmen erneut Kontakt auf und sorgten dort für eine Korrektur der Daten. Das war der entscheidende Hebel, der sich jedoch unterschiedlich auf die Tools auswirkte:

Dieses Beispiel zeigt eindrucksvoll, dass GEO / LLMO kein Buzzword ist, sondern ein notwendiger Prozess für Markenführung im KI-Zeitalter.

Mit GEO geht es nicht darum, die KI zu überlisten. Es geht darum, die Informationsarchitektur so aufzubereiten, dass die Wahrheit am einfachsten zu finden und zu verarbeiten ist.